Увод у алгоритме класификације

Овај чланак о алгоритмима за класификацију даје преглед различитих начина класификације који се обично користе у техникама вађења података са различитим принципима. Класификација је техника која категорише податке у различит број класа и заузврат се свакој класи додељују ознаке. Главни циљ класификације је идентификовање класе за покретање нових података анализом скупа обуке увидом у исправне границе. Опћенито, предвиђање циљне класе и горе наведени поступак назива се класификација.

На пример, руководство болнице бележи име, адресу, старост, претходну историју пацијентовог здравља да би их дијагностиковала, ово помаже да се класификују пацијенти. Они се могу окарактерисати у две фазе: фаза учења и фаза евалуације. Модели фаза учења база приступа не даје податке о обуци док фаза евалуације предвиђа излаз за дане податке. Њихове апликације могли бисмо пронаћи у нежељеној пошти путем е-поште, предвиђању банкарских кредита, препознавању говора, анализи осећаја. Техника укључује математичку функцију ф са улазом Кс и излазом И.

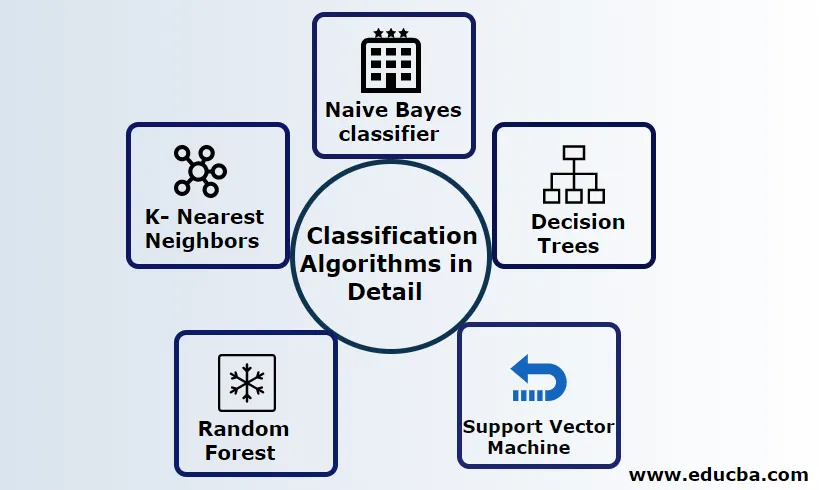

Објасните алгоритме класификације детаљно

Класификација се може извршити како на структурираним тако и на неструктурираним подацима. Класификација се може категорисати у

- Наивни Баиесов класификатор

- Дрвећа одлучивања

- Суппорт Вецтор Мацхине

- Рандом Форест

- К- Најближи суседи

1) Наиве Баиес-ов класификатор

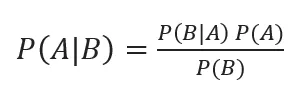

То је Баиесов алгоритам заснован на теореми, једна од статистичких класификација и захтева мало података о тренингу да би се проценили параметри такође познати као вероватноћа класификатора. Сматра се да је најбржи класификатор, високо скалабилан и обрађује дискретне и континуиране податке. Овај алгоритам се користио за предвиђање у реалном времену. Постоје различите врсте наивног класификатора, Мултиномиал Наиве Баиес, Берноулли Наиве Баиес, Гауссиан наиве.

Баиесову класификацију са задњим вероватноћама даје

Где су А, Б догађаји, П (А | Б) - постериорне вероватноће.

Ако су две вредности независне једна од друге,

П (А, Б) = П (А) П (Б)

Наиве Баиес се може градити користећи питхон библиотеку. Наивни предиктори су независни, иако се користе у системима препорука. Користе се у многим апликацијама у стварном времену и добро се користе у класификацији докумената.

Предности:

Предности су у томе што захтевају врло мање рачунске снаге, претпостављају се код проблема предвиђања више класа, тачно раде на великим скуповима података.

Недостатак:

Главни недостатак овог класификатора је да ће доделити нулту вероватноћу. И имају својства која су међусобно неовисна.

2) Стабло одлука

Ради се о моделу приступа одоздо на доље са структуром дијаграма тока обрађује податке високих димензија. Резултати се предвиђају на основу дате улазне варијабле. Стабло одлуке састављено од следећих елемената: корен, много чворова, грана, лишћа. Коренски чвор чини партицију на основу вредности атрибута класе, унутрашњи чвор узима атрибут за даљу класификацију, гране доносе одлуку о подели чворова на чворове листова, на крају, чворови листа дају нам коначни исход. Временска сложеност стабла одлука зависи од броја записа, атрибута података о обуци. Ако је стабло одлука предуго, тешко је добити жељене резултате.

Предност: Примењују се за предиктивну аналитику за решавање проблема и свакодневно се користе у свакодневним активностима за одабир циља на основу анализе одлука. Аутоматски гради модел на основу изворних података. Најбоље у руковању са недостајућим вредностима.

Недостатак: Величина стабла је неконтролирано све док нема одређених критеријума заустављања. Дрво је због хијерархијске структуре нестабилно.

3) Подршка векторска машина

Овај алгоритам игра виталну улогу у проблемима класификације и најчешће је алгоритам машинског учења под надзором. То је важно средство које користи истраживач и научник података. Овај СВМ је врло лак и његов процес је проналажење хиперплана у тачкама података Н-димензионалних простора. Хиперплане су границе одлука које класификују тачке података. Сав овај вектор пада ближе хиперплану, максимизирајући маржу класификатора. Ако је маржа максимална, најмања је грешка генерализације. Њихова се имплементација може обавити помоћу кернела користећи питхон с неким скуповима података о тренингу. Главни циљ СВМ-а је обучити објект у одређеној класификацији. СВМ није ограничен да постане линеарни класификатор. СВМ је пожељнији више од било ког модела класификације због своје функције кернела која побољшава рачунску ефикасност.

Предност: Они су веома пожељни због мање рачунске снаге и ефективне тачности. Ефикасан у великом димензионалном простору, добра ефикасност меморије.

Недостатак: Ограничења у брзини, језгри и величини

4) Случајна шума

То је моћан алгоритам машинског учења заснован на приступу ансамбла за учење. Основни грађевни блок Рандом шуме је стабло одлука које се користи за изградњу предиктивних модела. Демонстрација рада укључује креирање шуме стабала с случајним одлукама, а поступак обрезивања се врши постављањем зауставних дијелова како би се постигао бољи резултат. Случајна шума проводи се техником која се назива врећа за доношење одлука. Ово пакирање спречава прекомерно уклапање података смањујући пристраност слично као што овај случајни случај може постићи бољу тачност. Коначно предвиђање узима просек многих стабала одлука тј. Честа предвиђања. Насумична шума укључује многе случајеве употребе попут предвиђања берзи, детекције превара, предвиђања вести.

Предности:

- Не захтева велика обрада за обраду скупова података и врло једноставан модел за изградњу. Пружа већу тачност помаже у решавању проблема са предиктивом.

- Добро функционира у руковању недостајућим вриједностима и аутоматски открива вањски облик.

Недостатак:

- Захтева високе рачунске трошкове и велику меморију.

- Захтева много више временског периода.

5) К- Најближи суседи

Овде ћемо разговарати о К-НН алгоритму уз надгледано учење за ЦАРТ. Користе К позитивни мали цели број; објект се додељује класи на основу комшија или ћемо рећи додељивање групе посматрајући у којој групи комшија лежи. То се бира мером удаљености од Еуклидове удаљености и бруталном силом. Вредност К може се пронаћи помоћу поступка подешавања. КНН не жели да научи ниједан модел за обуку новог скупа података и употребу нормализације за скалирање података.

Предност: Даје ефикасне резултате ако су подаци о обуци огромни.

Недостатак: Највећи проблем је што ако је варијабла мала, она добро функционише. Друго, избор К фактора приликом класификације.

Закључак

Закључно, прошли смо кроз могућности различитих алгоритама класификације и даље делује као моћно средство у инжењерингу значајки, класификација слика која игра сјајан ресурс за машинско учење. Алгоритми за класификацију су моћни алгоритми који решавају тешке проблеме.

Препоручени чланци

Ово је водич за класификацијске алгоритме у машинском учењу. Овдје разматрамо да се Класификација може извести и на структурираним и на неструктурираним подацима. Можете и да прођете кроз друге наше предложене чланке -

- Алгоритми усмјеравања

- Алгоритам кластера

- Процес рударјења података

- Алгоритми машинског учења

- Најчешће коришћене технике ансамблиног учења

- Ц ++ алгоритам | Примери алгоритма Ц ++