Увод у једноставну линеарну регресију

Из речника : Повратак у пријашње или мање развијено стање.

У статистици: Мера односа између средње вредности једне променљиве и одговарајућих вредности осталих променљивих.

Регресија у којој се однос улазне варијабле (независна варијабла) и циљне варијабле (зависна варијабла) сматра линеарном назива се Линеарна регресија. Једноставна линеарна регресија је врста линеарне регресије у којој имамо само једну независну променљиву да предвидимо зависну променљиву. Једноставна линеарна регресија један је од алгоритама машинског учења. Једноставна линеарна регресија припада породици супервизираног учења. Регресија се користи за предвиђање континуираних вредности.

Модел једноставне линеарне регресије

Хајде да поједноставимо. Како је све почело?

Све је почело 1800. године са Францисом Галтоном. Проучавао је однос у висини између очева и њихових синова. Уочио је образац: Или ће висина сина бити висока као што је висина оца или висина сина обично ближа укупној просечној висини свих људи. Овај феномен није ништа друго него регресија.

На пример, Схак О'Неал је веома познати НБА играч и висок је 2, 16 метара. Његови синови Схакир и Схарееф О'неал високи су 1, 96 метара и 2, 06 метара. Просечна висина становништва је 1, 76 метара. Син висине регресира (помицање према) средњој висини.

Како да радимо регресију?

Израчунавање регресије са само две податковне тачке:

Све што желимо да учинимо како бисмо пронашли најбољу регресију је исцртати линију која је што ближа свакој тачки. У случају двије тачке података лако је повући црту, само им се придружите.

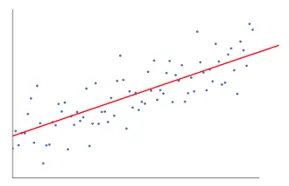

Ако сада имамо неколико тачака података, како цртати линију која је што ближа свакој тачки података.

У овом случају, наш циљ је да смањимо вертикално растојање између линије и свих тачака података. На овај начин предвиђамо најбољу линију за наш модел Линеарне регресије.

Шта је једноставна линеарна регресија?

Испод је детаљно објашњење Једноставне линеарне регресије:

- Нацртава пуно и пуно могућих линија линија, а затим обавља било коју од ових анализа.

- Збир грешака у квадрату.

- Збир апсолутних грешака.

- метода најмање квадрата… итд

- За нашу анализу користићемо метод најмање квадрата.

- Направићемо разлику свих тачака и израчунаћемо квадрат зброја свих тачака. Која год линија да минималну суму, биће наша најбоља линија.

На пример: Радећи ово могли бисмо узети више мушкараца и њихову висину и радити ствари попут рецимо мушкарцу колико може да буде његов син. пре него што се он уопште родио.

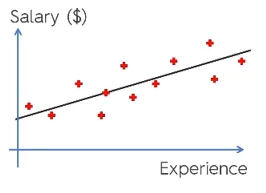

Гоогле Имаге

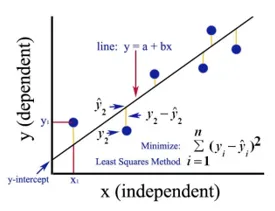

Горња слика приказује једноставну линеарну регресију. Линија представља линију регресије. Дати према: и = а + б * к

Где је и зависна варијабла (ДВ): На пример, како се плата особе мења у зависности од броја година искуства које запослени има. Дакле, овде ће зарада запосленог или особе зависити од ваше променљиве.

Зависна варијабла је наша циљна варијабла, она коју желимо предвидјети користећи линеарну регресију.

к је наша независна променљива (ИВ): зависна променљива је узрок промене независне променљиве. У горњем примеру, број година искуства је наша зависна варијабла, јер број година искуства узрокује промену плата запосленог.

- б је коефицијентна варијабла за нашу независну променљиву к. Овај коефицијент игра пресудну улогу. Каже како ће промена јединице у к (ИВ) утицати на и (ДВ). Назива се и коефицијентом пропорционалне. Што се математике тиче, на вама је нагиб линије или можете рећи стрми од линије.

- У нашем примеру, ако је нагиб (б) мањи, што значи да ће број година донети мањи пораст плата, с друге стране ако ће нагиб (б) бити већи, то ће повећати плату са повећањем броја Године искуства.

- а је константна вредност. Назива се и као пресретање, тамо где линија пресече оси и или ДВ. На други начин можемо рећи када запослени има нулта година искуства (к), тада ће плата (и) за тог запосленика бити константна (а).

Како функционира Леаст Скуаре?

Испод су тачке за најмање квадратни рад:

- Нацртаје произвољну линију према трендовима података.

- Потребне су тачке података и цртају вертикалне линије. Вертикално растојање сматра параметром.

- Ове вертикалне линије пресећи ће регресијску линију и дати одговарајућу тачку за тачке података.

- Тада ће се наћи вертикална разлика између сваке тачке података и одговарајуће тачке података на регресијској линији.

- Израчунаће грешку која је квадратна од разлике.

- Затим израчунава суму грешака.

- Затим ће поново повући црту и још једном поновити горњи поступак.

- На овај начин црта бројне линије, а линија која даје најмању количину грешке је изабрана за најбољу линију.

- Ова најбоља линија је наша једноставна линеарна регресијска линија.

Примена једноставне линеарне регресије

Регресијска анализа се изводи да би се предвидјела континуирана променљива. Регресијска анализа има широку употребу. Неки примери су следећи:

- Предиктивна аналитика

- Ефикасност маркетинга,

- цене било ког уноса

- предвиђање промоције производа.

Овде ћемо разговарати о једној примени линеарне регресије за предиктивну аналитику. Ми ћемо се бавити моделом користећи питхон.

Кораци које ћемо слиједити да бисмо изградили наш модел су сљедећи:

- Увезићемо библиотеке и скупове података.

- Податке ћемо претходно обрадити.

- Поделит ћемо податке на тест и сет за тренинг.

- Направићемо модел који ће покушати да предвиди циљну варијаблу на основу нашег скупа тренинга

- Предвидићемо циљну варијаблу за тестни скуп.

- Анализираћемо резултате предвиђене моделом

За нашу анализу користићемо податке о платама са подацима о 30 запослених.

# Увоз библиотека

import numpy as np

import matplotlib.pyplot as plt

import pandas as pd

# Увоз базе података (узорак података је приказан у табели)

dataset = pd.read_csv('Salary_Data.csv')

| Године искуства | Плата |

| 1.5 | 37731 |

| 1.1 | 39343 |

| 2.2 | 39891 |

| 2 | 43525 |

| 1.3 | 46205 |

| 3.2 | 54445 |

| 4 | 55749 |

# Претходна обрада скупа података, овде ћемо поделити скуп података на зависну и независну варијаблу. к као независна и и као зависна или циљна варијабла

X = dataset.iloc(:, :-1).values

y = dataset.iloc(:, 1).values

# Дељење скупа података у сет за тренинг и тест тест:

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size = 1/3, random_state = 0)

Овде величина теста 1/3 показује да је од укупних података 2/3 део за обуку модела, а остатак 1/3 се користи за тестирање модела.

# Прилагодимо наш једноставни модел линеарне регресије у сет за тренинг

from sklearn.linear_model import LinearRegression

regressor = LinearRegression()

regressor.fit(X_train, y_train)

Модел линеарне регресије сада је обучен. Овај модел ће се користити за предвиђање зависне променљиве.

# Предвиђање резултата теста

y_pred = regressor.predict(X_test)

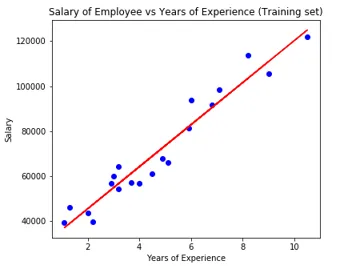

# Визуализација резултата теста

plt.scatter(X_test, y_test, color = 'blue')

plt.plot(X_train, regressor.predict(X_train), color = 'red')

plt.title('Salary of Employee vs Experience (Test set)')

plt.xlabel('Years of Experience')

plt.ylabel('Salary')

plt.show()

# Параметар модела

print(regressor.intercept_)

print(regressor.coef_)

26816.19224403119

(9345.94244312)

Дакле, вредност пресретања (а) је 26816. Што сугерира да би било који свежији (нулта искуство) добио око 26816 износа као плаће.

Коефицијент за наш модел је изашао као 9345, 94. Сугерише да ће задржавање свих осталих параметара константно, промена једне јединице независне променљиве (године искуства) донети промену у плати од 9345 јединица.

Мјерне вриједности регресије

За регресијску анализу су на располагању три важне методе метричке евалуације:

- Средња апсолутна грешка (МАЕ): Показује средњу вредност апсолутних грешака, која је разлика између предвиђене и стварне.

- Средња грешка у квадрату (МСЕ): Показује средњу вредност квадратних грешака.

- Роот Средња квадратна грешка (РМСЕ): Приказује квадратни корен средње вредности квадратних грешака.

Наведене методе можемо упоредити са овим:

- МАЕ: Показује просечну грешку и најлакшу од све три методе.

- МСЕ: Овај је популарнији од МАЕ-а јер повећава веће грешке, што резултира више увида.

- РМСЕ: Овај је бољи од МСЕ-а јер грешку можемо интерпретирати у смислу и.

Ове 3 су само функције губитка.

# Евалуација модела

from sklearn import metrics

print('MAE:', metrics.mean_absolute_error(y_test, y_pred))

print('MSE:', metrics.mean_squared_error(y_test, y_pred))

print('RMSE:', np.sqrt(metrics.mean_squared_error(y_test, y_pred)))

MAE: 3426.4269374307123

MSE: 21026037.329511296

RMSE: 4585.4157204675885

Закључак

Линеарна регресијска анализа је моћан алат за алгоритме машинског учења, који се користи за предвиђање континуираних варијабли попут плате, продаје, перформанси итд. Линеарна регресија разматра линеарни однос између независних и зависних променљивих. Једноставна линеарна регресија има само једну независну варијаблу на основу које модел предвиђа циљану варијаблу. Размотрили смо модел и примену линеарне регресије са примером предиктивне анализе за предвиђање плата запослених.

Препоручени чланци

Ово је водич за једноставну линеарну регресију. Овде смо расправљали о моделу и примени линеарне регресије, користећи пример предиктивне анализе за предвиђање плата запослених. Можете и да прођете кроз наше друге сродне чланке да бисте сазнали више -

- Линеарна регресијска анализа

- Линеарна регресија у Р

- Линеарно регресијско моделирање

- Регресијско испитивање

- Матплотлиб Ин Питхон | Топ 14 парцела у Матплотлибу

- Речник у Питхон-у | Методе и примери

- Примери квадратног корена у ПХП-у

- Линеар Регрессион вс Логистиц Регрессион | Топ разлике