Увод у методе машинског учења

Следећи чланак, Методе машинског учења даје преглед најчешће коришћених метода у машинском учењу. Машинско учење је техника која рачунару омогућава да 'научи' ствари самостално. Алгоритми адаптивно побољшавају своје перформансе како се повећавају подаци доступни за учење. То је више података, тачнији би био наш модел.

Како машине уче?

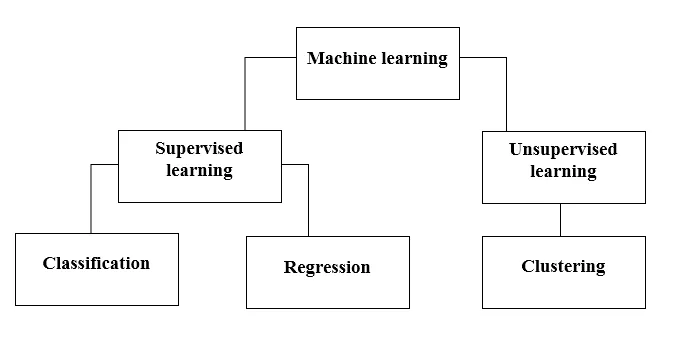

Постоје разни методи за то. Који метод потпуно следити зависи од изјаве проблема. У зависности од скупа података и нашег проблема, постоје два различита начина за дубље напредовање. Један је учење под надзором, а други учење без надзора. Следећи графикон објашњава даљу класификацију метода машинског учења. Разговараћемо о њима један по један.

Погледајте следећи графикон!

Хајде да разумемо шта значи надгледано учење.

Надзирано учење

Као што име говори, замислите учитеља или супервизора који ће вам помоћи да учите. Исто важи и за машине. Машину тренирамо или подучавамо користећи податке који су означени.

Неке од најбољих апликација које се надгледају су:

- Анализа осјећаја (Твиттер, Фацебоок, Нетфлик, ИоуТубе, итд.)

- Обрада природног језика

- Класификација слике

- Предиктивна анализа

- Препознавање узорка

- Откривање нежељене поште

- Говор / Секвенца обрада

Сада је под надзором учење даље подељено на класификацију и регресију. Да разумемо ово.

Класификација

Класификација је процес проналажења модела који помаже да се подаци раздвоје у различите категоричке класе. У овом се процесу подаци категоризирају под различитим наљепницама према неким параметрима даним у улазу и тада се предвиђају ознаке за податке. Категорично значи да је излазна варијабла категорија, тј. Црвена или црна, нежељена или нежељена, дијабетичка или не-дијабетичка итд.

Модели класификације укључују векторску машину за подршку (СВМ), К-најближег суседа (КНН), Наиве Баиес итд.

а) Машински класификатор подршке (СВМ)

СВМ је надзирани начин учења који гледа податке и разврстава их у једну од две категорије. Користим хиперплане за категоризацију података. Линеарни дискриминативни класификатор покушава нацртати правац који раздваја два скупа података и на тај начин ствара модел за класификацију. Једноставно покушава пронаћи линију или кривуљу (у двије димензије) или раздјелник (у више димензија) који дијеле класе једна од друге.

Напомена - За класификацију у више класа СВМ користи 'један према остатку', то значи израчунавање различитих СВМ за сваку класу.

б) К-најближи класификатор суседа (КНН)

- Ако пажљиво прочитате, само име сугерира шта алгоритам ради. КНН сматра да су тачке података које су ближе, много сличније у погледу карактеристика, па стога вероватније припадају истој класи као и комшије. За сваку нову тачку података израчунава се удаљеност до свих осталих тачака података и класа се одлучује на основу К најближих сусједа. Да, можда звучи хромо, али за неке класификације делује као било шта.

- Точка података класификује се према максималном броју гласова својих суседа, а затим се тачка података додељује најближој класи међу к-суседима.

- У КНН-у није потребно учење модела и сав рад се дешава у тренутку када се тражи предвиђање. Зато се КНН често назива алгоритам за лењо учење.

ц) Наиве Баиесовог класификатора

- Наиве Баиес је алгоритам машинског учења који се топло препоручује код проблема са класификацијом текста. Заснован је на Баиесовој теореми вероватноће. Ове класификаторе називамо наивним, јер претпостављају да варијабле карактеристика нису међусобно независне. То значи, на пример, да имамо целу реченицу за унос, тада Наиве Баиес претпоставља да је свака реч у реченици независна од осталих. А затим их класификујте у складу са тим. Знам да изгледа прилично наивно, али је одличан избор за проблеме с класификацијом текста и популаран је избор за класификацију нежељене поште.

- Омогућава различите типове алгоритама за Наиве Баиес-а као што су БерноуллиНБ, ГауссианНБ, МултиномиалНБ.

- Сматра да су све карактеристике неповезане, па не може да научи однос између функција. На пример, рецимо, Варун воли да једе хамбургере, такође воли јести помфрит са коксом. Али он не воли заједно да једе хамбургер и комбинацију помфрита и кокса. Овде Наиве Баиес не може да научи однос између две особине, већ само учи само о значају појединца.

А сада пређимо на другу страну нашег надзираног начина учења, а то је регресија.

Регресија

Регресија је процес проналаска модела који помаже у разликовању података користећи континуиране вриједности. При томе је наручена природа предвиђених података. Неки од најчешће кориштених регресијских модела укључују линеарну регресију, случајну шуму (стабла одлука), неуронске мреже.

Линеарна регресија

- Један од најједноставнијих приступа у супервизираном учењу, који је користан за предвиђање квантитативног одговора.

- Линеарна регресија укључује проналажење најбоље одговарајуће равне линије кроз тачке. Линија која најбоље пристаје назива се регресијска линија. Линија најбољег прилагођавања не пролази точно кроз све тачке података, али уместо тога покушава се најбоље приближити њима.

- То је широко кориштен алгоритам за непрекидне податке. Међутим, фокусира се само на средину зависне променљиве и ограничава се на линеарни однос.

- Линеарна регресија може се користити за временске серије, предвиђање трендова. На основу претходних података може предвидјети будућу продају.

Ненадзоровано учење

- Ненадзоровано учење заснива се на приступу који се може сматрати одсуством наставника, а самим тим и апсолутним мерама грешке. Корисно је када је потребно да научите групирање или групирање елемената. Елементи се могу груписати (груписати) према њиховој сличности.

- Код учења без надзора, подаци се обележавају без класификације, а алгоритми система делују на податке без претходне обуке. Ненадзорани алгоритми учења могу обављати сложеније задатке од алгоритама учења под надзором.

- Ненадзоровано учење укључује кластерирање које се може учинити коришћењем К значи кластерирање, хијерархијско, Гауссово мешање, скривени Марков модел.

Апликације које се не надгледају су:

- Откривање сличности

- Аутоматско означавање

- Сегментација објеката (као што су Особа, Животиње, Филмови)

Кластерирање

- Кластерирање је ненадзирана техника учења која се користи за анализу података у многим областима. Алгоритам кластерирања је користан када желимо стећи детаљне увиде о нашим подацима.

- Реални пример кластерирања били би Нетфликови жанровски кластери, који су подељени за различите циљне купце, укључујући интересе, демографију, начин живота, итд. Сада можете размислити о томе колико је корисно кластерирање када компаније желе да разумеју своју корисничку базу и циљају нови потенцијал купаца.

а) К значи Кластерирање

- К значи алгоритам кластерирања покушава да подели дате непознате податке у кластере. Случајно одабире 'к' центроид кластера, израчунава удаљеност између тачака података и централе кластера, а затим коначно додељује тачку података центроиду кластера чија је удаљеност минимална од свих центроида кластера.

- У к-средствима, групе су дефинисане најближим центроидом сваке групе. Овај центроид делује као "мозак" алгоритма, они стичу тачке података које су им најближе и затим их додају у кластере.

б) Хијерархијско кластерирање

Хијерархијско кластерирање је готово слично ономе уобичајеног кластерирања осим ако не желите да изградите хијерархију кластера. Ово може бити корисно када желите одредити број кластера. На пример, претпоставимо да стварате групе различитих предмета у мрежи продавница. На насловној почетној страници желите неколико широких ставки и када кликнете на једну од ставки, отварају се одређене категорије, односно одређени кластери.

Смањење димензија

Смањење димензија може се сматрати компресијом датотеке. То значи, вађење информација које нису релевантне. Смањује сложеност података и покушава задржати значајне податке. На пример, компресијом слике смањујемо димензионалност простора у коме слика остаје онаква каква јесте, а да притом не уништавате превише значајног садржаја на слици.

ПЦА за визуелизацију података

Анализа главних компоненти (ПЦА) је метода смањења димензија која може бити корисна за визуализацију ваших података. ПЦА се користи за компримирање података већих димензија на податке са нижим димензијама, то јест, можемо користити ПЦА да смањимо четверодимензионалне податке у три или 2 димензије, тако да можемо да визуелизујемо и боље разумијемо податке.

Препоручени чланци

Ово је водич за Методе машинског учења. Овде смо разговарали о уводу, Како машине уче? класификације машинског учења и дијаграма тока са детаљним објашњењем. Можете и да прођете кроз друге наше предложене чланке да бисте сазнали више -

- Архитектура машинског учења

- Оквири машинског учења

- Алати за машинско учење

- Технике машинског учења

- Машинско учење хиперпараметра

- Хијерархијски алгоритам кластерирања

- Хијерархијско кластерирање | Агломеративно и подељено кластерирање