Увод у назадно уклањање

Како човек и машина куцају према дигиталној еволуцији, разне машине рачунаре рачунају да се не само обуче већ и паметно обуче како би изашле са бољим препознавањем објеката у стварном свету. Таква техника која је раније уведена под називом „назадно уклањање“ која је намеравала да фаворизује неопходне карактеристике, док истискује нужне карактеристике да би се омогућила бољој оптимизацији у машини. Читава способност машинског препознавања објеката сразмерна је оним што има у виду.

Карактеристике које немају референцу на предвиђени излаз морају се испразнити из машине и закључити је елиминацијом уназад. Добра прецизност и временска сложеност машинског препознавања било којег стварног речи речи зависе од његовог учења. Дакле, елиминација уназад игра своју круту улогу у избору карактеристика. Он рачуна стопу зависности обележја за зависну променљиву и проналази значај њене припадности у моделу. Да би ово акредитовао, он проверава обрачунату стопу са стандардним нивоом значајности (рецимо 0, 06) и доноси одлуку за избор значајки.

Зашто повлачимо назадно уклањање ?

Небитне и сувишне особине покрећу сложеност машинске логике. Беспотребно прождире време и ресурсе модела. Дакле, горе поменута техника игра компетентну улогу да кривотвори модел на једноставан. Алгоритам његује најбољу верзију модела оптимизирањем његових перформанси и искориштавањем потрошених ресурса.

То смањује најмање значајне карактеристике модела које изазивају буку у одлучивању регресијске линије. Нерелевантне особине објекта могу довести до погрешне класификације и предвиђања. Небитне карактеристике ентитета могу представљати неусклађеност модела у односу на друга значајна својства других објеката. Елиминација уназад подстиче прилагођавање модела најбољем случају. Због тога се за модел препоручује елиминација уназад.

Како применити назадно уклањање?

Елиминација уназад започиње са свим варијаблама карактеристика, тестирајући је са зависном променљивом према изабраном критеријуму модела. Почиње искорјењивати оне варијабле које погоршавају доликујућу регресију. Понављање тог брисања све док модел не постигне добру кондицију. Испод су кораци за вежбање уклањања уназад:

Корак 1: Изаберите одговарајући ниво значајности који ће се налазити у моделу машине. (Узми С = 0, 06)

Корак 2: Напуните све доступне независне варијабле модела с обзиром на зависну варијаблу и нагиб рачунара и пресретање да бисте нацртали линију регресије или линију уклапања.

Корак 3: Пређите са сваком независном променљивом која има највећу вредност (Таке И), једну по једну и наставите са следећим здравицом: -

а) Ако сам> С, изведите 4. корак.

б) Прекини и модел је савршен.

Корак 4: Уклоните изабрану варијаблу и повећајте оси.

Корак 5: Поново направите модел и поново израчунајте нагиб и пресретање одговарајуће линије уз преостале варијабле.

Горе наведени кораци сумирани су у одбацивање оних карактеристика чија је стопа значаја изнад одабране вредности значајности (0, 06) да би се избјегло прекомјерно класифицирање и прекомјерна употреба ресурса која је посматрана као велика сложеност.

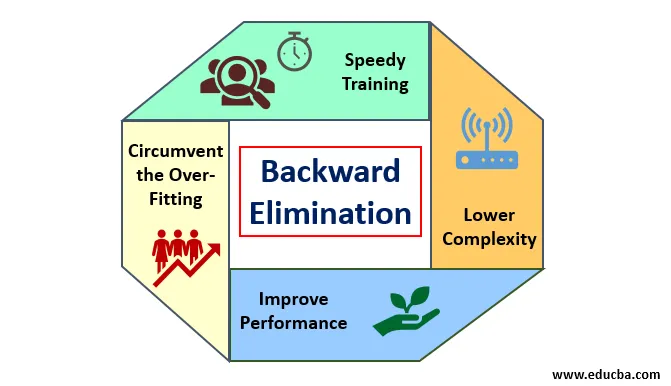

Заслуге и мане заостале елиминације

Ево неколико заслуга и недостатака назадног уклањања, који су детаљно наведени у наставку:

1. Заслуге

Заслуге назадне елиминације су следеће:

- Брза обука: Машина је обучена са низом доступних функција узорка које се раде у врло кратком времену ако се из модела уклоне небитне карактеристике. Брза обука скупа података долази у слику само када се модел бави значајним карактеристикама и искључује све варијабле буке. Црта једноставну сложеност за тренинг. Но, модел се не смије подвргнути недовољној прилагодби која се јавља због недостатка карактеристика или неадекватних узорака. Карактеристика узорка треба бити обилна у моделу за најбољу класификацију. Време потребно за обуку модела требало би да буде мање уз одржавање прецизности класификације и не би требало да постоји варијабла под-предвиђања.

- Нижа сложеност: Сложеност модела је велика ако модел разматра опсег функција укључујући буку и неповезане функције. Модел троши много простора и времена да би се обрадио такав распон карактеристика. Ово може повећати стопу тачности препознавања узорака, али брзина може такође садржавати и буку. Да бисте се ослободили тако велике сложености модела, алгоритам елиминације уназад игра неопходну улогу повлачењем нежељених карактеристика из модела. Поједностављује логику обраде модела. Само неколико суштинских карактеристика је довољно да се направи добар фит који садржи разумну тачност.

- Побољшајте перформансе: Учинак модела зависи од многих аспеката. Модел се подвргава оптимизацији користећи назад елиминацију. Оптимизација модела је оптимизација скупа података који се користи за обуку модела. Учинак модела директно је пропорционалан брзини његове оптимизације која се ослања на учесталост значајних података. Процес елиминације уназад није намијењен покретању измјена из било којег нискофреквентног предвиђача. Али измена започиње само из података високих фреквенција, јер углавном сложеност модела зависи од тог дела.

- Заобићи прекомерно уклапање: Ситуација са прекомерним уклапањем настаје када је модел добио превише скупова података и када се врши класификација или предвиђање у којима су неки предвиђали буку других класа. У овом намештању модел би требао да даје неочекивано високу тачност. Приликом прекомерног уклапања, модел можда неће класификовати променљиву због конфузије створене у логици због превише стања. Техника уклањања уназад смањује вањску карактеристику да би се заобишла ситуација прекомерног намештања.

2. Демеритс

Слабости назадног уклањања су сљедеће:

- У назадној методи елиминације не може се сазнати који је предиктор одговоран за одбацивање другог предиктора због његовог достизања до безначајности. На пример, ако предиктор Кс има неки значај који је био довољно добар да остане у моделу након додавања И предиктора. Али значај Кс-а застарева када у модел уђе још један предиктор З. Дакле, алгоритам елиминације уназад не показује никакву зависност између два предиктора који се дешавају у „техници одабира напријед“.

- После одбацивања било које карактеристике модела помоћу алгоритма за уклањање уназад, та се функција не може поново изабрати. Укратко, елиминација уназад нема флексибилан приступ додавању или уклањању функција / предиктора.

- Норме за избор вредности значајности (0, 06) у моделу су нефлексибилне. Елиминација уназад нема флексибилну процедуру да не само да одабере, већ и да промени безначајну вредност према потреби како би се постигао најбољи фит у одговарајућем скупу података.

Закључак

Техника елиминације уназад реализована је ради побољшања перформанси модела и оптимизације његове сложености. Живо се користи у више регресија, где се модел бави опсежним подацима. То је једноставан и једноставан приступ у поређењу са селекцијом напријед и унакрсном валидацијом у којој се јавља преоптерећење оптимизације. Техника елиминације уназад иницира елиминацију карактеристика веће вредности. Његов основни циљ је учинити модел мање сложеним и забранити прекомерно уклапање ситуације.

Препоручени чланци

Ово је водич за назадно уклањање. Овде смо разговарали о томе како применити елиминацију уназад, заједно са заслугама и недостацима. Такође можете погледати следеће чланке да бисте сазнали више -

- Машинско учење хиперпараметра

- Кластерирање у машинском учењу

- Јава Виртуал Мацхине

- Ненадзоровано машинско учење